全球AI基准评测MLPerf近日揭榜,国产黑马浮现。

MLPerf Inference v2.1榜单于9月公布最新结果,多家行业头部公司参与竞争,而墨芯人工智能S30计算卡在开放任务(Open division)测试环境下,以95784 FPS的单卡算力,夺得Resnet-50模型算力全球第一。同时,墨芯S30运行BERT-Large高精度自然语言处理模型(99.9%)时单卡算力达3837SPS,为英伟达A100的2倍,仅次于英伟达H100。

“这个成绩的亮点在于它展现了我们技术路线所实现的效果,也使得这条技术路线成为大家关注的焦点。”墨芯人工智能创始人王维近日接受界面新闻等媒体采访时表示。

墨芯人工智能(Moffett AI)成立于2018年,总部位于深圳,主要研发云端和终端AI芯片加速方案,创始团队来自卡内基梅隆大学。成立之后,墨芯曾获得凯旋创投、创享基金和云天使基金的天使轮投资,浪潮云海基金战略投资,将门创投、真格基金的Pre-A轮,以及基石资本、大湾区共同家园发展基金,同威资本、华盛资本、深圳天使母基金的A轮投资。

此次测试中,墨芯主打的“稀疏化计算”技术,成为MLPerf测试中实现突破的主要因素,据称该技术能够加速AI计算。

所谓“稀疏化计算”,是一种以人脑得到灵感的模型压缩方法。其过程类似于抽走积木的“叠叠乐”游戏,即保证AI模型不会“坍塌”的同时,通过优化模型,抽走部分参数,以减少深度学习所需的矩阵计算减少计算量,从而缩短取得准确结果的时间,压缩稀疏矩阵还可以减少占用宝贵的内存和带宽。其应用场景几乎覆盖所有AI加速计算模型,包括时下流行的AI“大模型”。

在技术积累上,墨芯首创双稀疏算法,拥有超过30项稀疏化全球专利,首款Antoum处理器芯片已经出货,可实现32倍最高稀疏率。纵观海内外,墨芯所处的此类技术路线少有类似者。

实际上,对于稀疏化计算,学界已有前期探索。过去,研究人员尝试多种技术,抽出参数部分的权重甚至达到了神经网络的95%。但在整个过程中,模型精简所花的时间要远多于他们所节省的时间,还需要付出巨大的努力来弥补精简后的模型精度。此外,适用于一种模型的精简方法往往并不适用于其他模型。

尽管在现实应用中,AI计算仍以相对于稀疏计算的稠密数学计算(dense math)为主,但在AI模型逐渐通用化,以及模型规模急剧膨胀的情况下,如何通过内部模型稀疏化进行加速,将对AI计算层面产生重大影响,因此稀疏化计算近年获得了产业层面应用。以英伟达为例,其在Ampere架构A100 GPU中引入稀疏性支持,可以减少一半权值(即2倍稀疏率)来训练神经网络。

王维表示,在稀疏化的效果上,目前墨芯计算卡已经能够达到4至32倍稀疏率,通过计算卡优化模型,这个过程是“一劳永逸”的,即优化完成后,对AI模型的加速效果可以长久实现。他提到,相较于英伟达,更高的稀疏倍率,意味着在算力、成本、能效比上存在更好的优化空间。

他以目前业界流行的自然语言大模型GPT-3为例称,GPT-3拥有1700多亿参数,若使用GPU来运行模型,需要10张A100的加速卡才能运行,但应用稀疏化算法,一张墨芯S30卡就可以让GPT-3模型跑起来,从而节省成本。

除算法模型层面的稀疏化外,和英伟达以及其他AI芯片公司相同,墨芯也参与芯片、计算卡、开发工具的“全栈”工具链开发。人员构成上,墨芯软硬件开发人员比例为6:4,在软件层面投入的人才更多。

王维解释,尽管稀疏化计算更多是算法层面的事情,但墨芯仍然参与芯片和计算卡开发的原因在于,其主打从算法出发的软硬协同设计,以实现最好的加速效果,“算法的创新虽然是核心创新点,但在有了理论的创新外,还要考虑软硬件的平台支撑,把数学理论变成最终的计算效果。”

据王维透露,墨芯下一步将会在做好稀疏化推理平台的基础上布局稀疏化训练,预计新一代产品将于明年底正式推出。

博威合金BOWAY

博威合金BOWAY 马扎克Mazak

马扎克Mazak 威尔泰克

威尔泰克 迈格泰克

迈格泰克 斯巴特

斯巴特 MAOSHENG贸盛

MAOSHENG贸盛 Miller米勒

Miller米勒 新世纪焊接

新世纪焊接 西安恒立

西安恒立 上海特焊

上海特焊 新天激光

新天激光 海目星激光

海目星激光 迅镭激光

迅镭激光 粤铭YUEMING

粤铭YUEMING 镭鸣Leiming

镭鸣Leiming 领创激光

领创激光 天琪激光

天琪激光 亚威Yawei

亚威Yawei 邦德激光bodor

邦德激光bodor 扬力YANGLI

扬力YANGLI 宏山激光

宏山激光 楚天激光

楚天激光 百超迪能NED

百超迪能NED 金运激光

金运激光 LVD

LVD Tanaka田中

Tanaka田中 BLM

BLM 易特流etal

易特流etal 百盛激光

百盛激光 Messer梅塞尔

Messer梅塞尔 PrimaPower普玛宝

PrimaPower普玛宝 Salvagnini萨瓦尼尼

Salvagnini萨瓦尼尼 奔腾激光PENTA LASER

奔腾激光PENTA LASER 华工HGTECH

华工HGTECH Bystronic百超激光

Bystronic百超激光 TRUMPF通快

TRUMPF通快 全自动焊接流水线

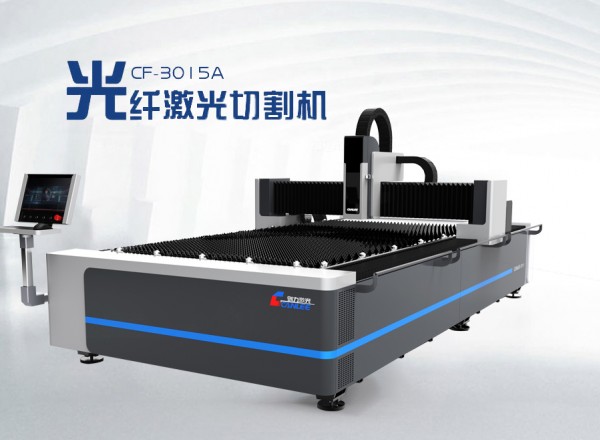

全自动焊接流水线 创力 CANLEE光纤激光切割机

创力 CANLEE光纤激光切割机 上海通用电气 全焊机系列展示

上海通用电气 全焊机系列展示 松下 旗下LAPRISS机器人激光焊接系统

松下 旗下LAPRISS机器人激光焊接系统 KUKA 库卡摩多机器人流水线作业

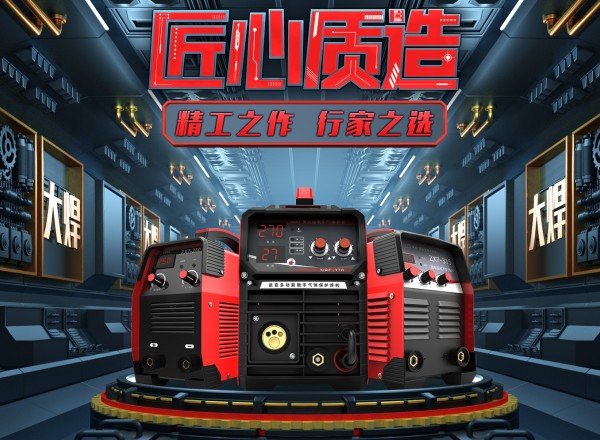

KUKA 库卡摩多机器人流水线作业 大焊 焊机匠心品质 精工之作 行家之选

大焊 焊机匠心品质 精工之作 行家之选 川崎工业焊接机器人 焊接管架

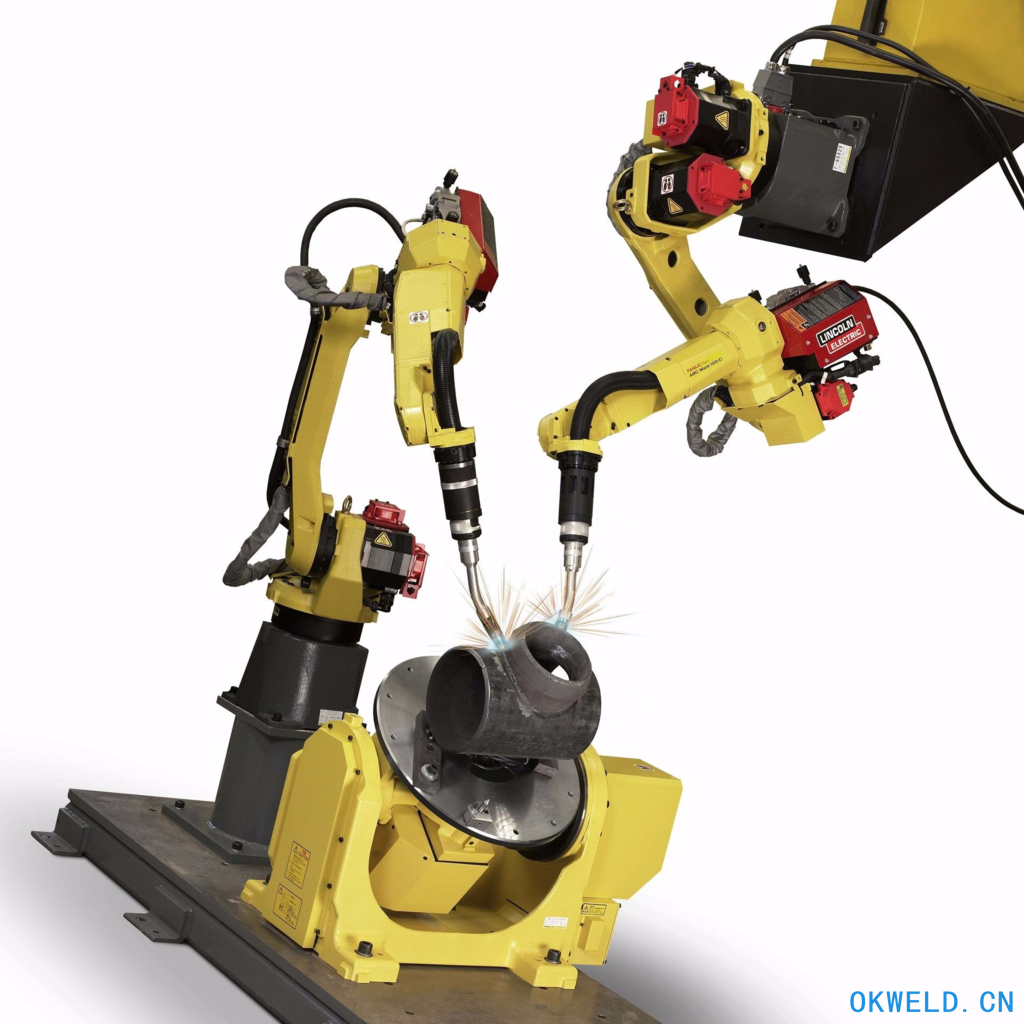

川崎工业焊接机器人 焊接管架 进口发那科焊接机器人FANUC- M-10IAM-10IA

进口发那科焊接机器人FANUC- M-10IAM-10IA 工业焊接机器人 气保焊自动填丝焊接机器人 氩弧焊接 管板焊接

工业焊接机器人 气保焊自动填丝焊接机器人 氩弧焊接 管板焊接 法兰式保温气动球阀BQ641PPL

法兰式保温气动球阀BQ641PPL 焊接机器人、宁波焊接机器人、工装夹具、自动焊接机、山东

焊接机器人、宁波焊接机器人、工装夹具、自动焊接机、山东 联合创新焊锡机 焊锡机器人价格 自动焊锡机价格 全自动焊锡机 深圳焊锡机价格 焊接机价格 东莞焊锡机 福州焊锡机

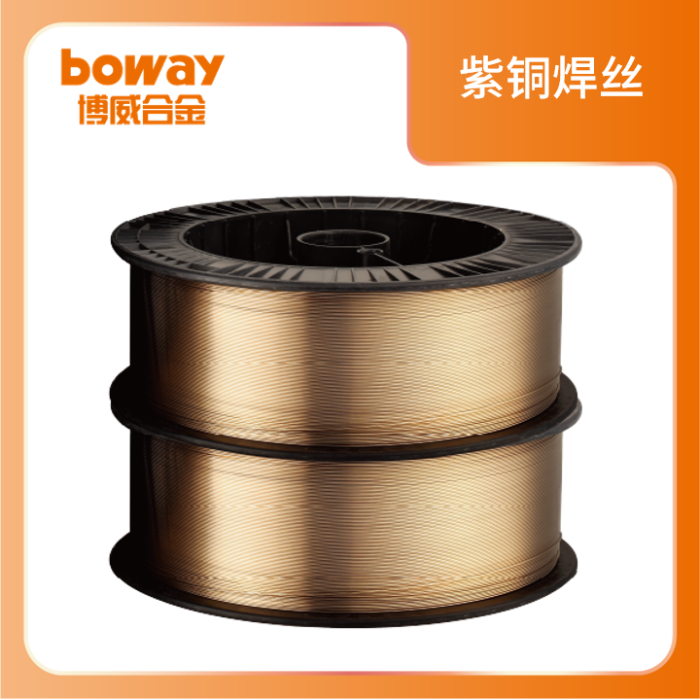

联合创新焊锡机 焊锡机器人价格 自动焊锡机价格 全自动焊锡机 深圳焊锡机价格 焊接机价格 东莞焊锡机 福州焊锡机 bw CuSn1 (HS201)紫铜焊丝焊接工艺性能优良

bw CuSn1 (HS201)紫铜焊丝焊接工艺性能优良 济南华鹿塑料焊接厂供应塑料焊接和HL塑料焊条 焊接塑料水箱 PVC焊条 PVC软板焊条 塑料焊条

济南华鹿塑料焊接厂供应塑料焊接和HL塑料焊条 焊接塑料水箱 PVC焊条 PVC软板焊条 塑料焊条 林肯中天ZX7-200电焊机手工焊不锈钢电焊机220v小型家用

林肯中天ZX7-200电焊机手工焊不锈钢电焊机220v小型家用