01.为啥车企偏爱激光雷达

车载激光雷达可以通过计算激光到达被摄物体的时间精确判断相对距离,并通过生成的点云对周围环境成像。这种工作原理使激光雷达可以无视被摄物体的材质、颜色以及环境明暗等外部因素,快速准确的输出结果,对于高速行驶的汽车来说至关重要。在所有前装量产车市场里,除了业界鼻祖 Mobileye 和 不走寻常路的 Tesla 坚定的选择纯视觉感知路线外,其他汽车厂商大多都会在高端车型中加入激光雷达用于辅助决策。

激光雷达成像效果演示

有了激光雷达的加入,车辆就能在夜间无照明路段或进出隧道等大光比场景下及时发现前方障碍物并引导车辆躲避和制动,也能在高速巡航时对施工占道物体提前预警,这将大大提升车辆辅助驾驶过程中的安全性和舒适性。

当然,任何技术都有优劣势,激光雷达也不是无所不能的。首先就是极端天气下无法工作,例如大雾、沙尘暴等非晴朗气候条件下,红外线透波率降低会导致激光雷达作用距离减小甚至完全无效。二是激光雷达无法感知色彩信息,对于交通信号灯和其他标志的识别无能为力。三是对数据处理的需求较高,目前市面上主流的激光雷达出点数基本都在 150 万/秒左右,既每秒能产生 150 万个探测点,且每个点具有独立的三维坐标信息,车载计算机必须在短时间内进行分析决策,这对车辆电子电气架构和硬件整合能力提出了更高的要求。最后就是老生常谈的价格问题,虽然目前激光雷达的采购价格已经降低到万元以内,甚至一些规格较低的能到千元级,但有的产品动辄配置两个甚至四个激光雷达,整体成本的提升对消费者来说仍有较大压力,与白菜价的摄像头相比更是天壤之别。

对于车企来说,在软件实力和数据积累比较薄弱的情况下,采用激光雷达方案可以通过少量的资金投入快速提高自身辅助驾驶系统的可用程度,抢占市场份额以获取更高的主动权。

02. 做自动驾驶,买一台激光雷达就万事大吉了吗?

当然不是,我们知道摄像头获取的图像是 2D 数据,信息丰富程度是够了,但是很难对深度信息和速度做出准确判断,而激光雷达获取的是 3D 数据,这恰恰是它最擅长的地方。如何才能把摄像头产生的 2D 画面与激光雷达产生的 3D 画面准确的映射在一起,就成了自动驾驶开发中的关键问题。

在传统的开发模式中,每个传感器互相独立,前向主视觉摄像头依然在环境感知和决策中占据主导地位,其他设备更多的是起到对数据交叉验证的作用,无法深度参与到整个规控流程。这种情况下,即便是激光雷达,也很难发挥其优势,只能在 AEB 主动紧急制动等少数场景做针对性的优化,大多数场景下与未搭载激光雷达的车型没有体验上的差距。更尴尬的是,一旦各个传感器得到的数据出现较大的误差,那么分析决策的过程就会变的混乱且低效。

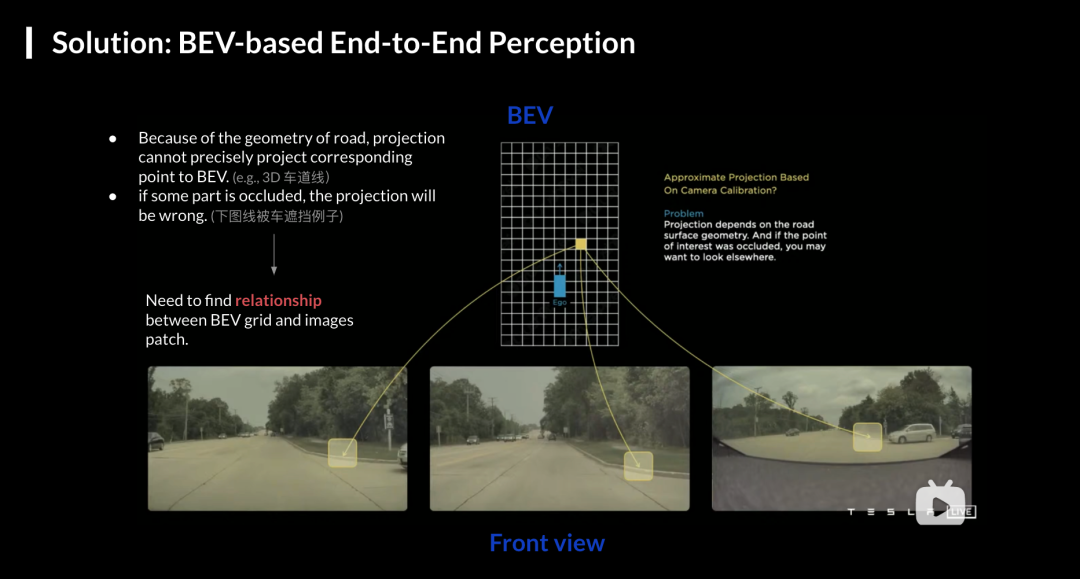

为了解决多传感器数据融合判断的难题,Tesla 自 2021 年起在全新的 FSD beta 版本中,引入了 BEV 技术进行环境感知。BEV 全称 Bird’s eye view,也就是鸟瞰图,BEV 感知算法的本质是多传感器融合背景下的一种视角表达形式,可以使多个传感器数据在相同视角下表达。

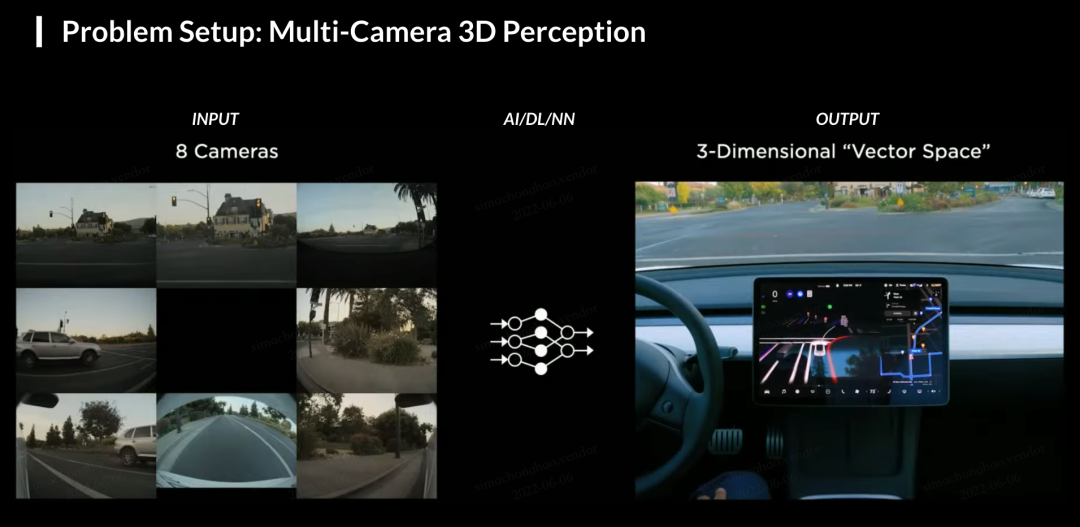

多摄像头下的 BEV 感知

通过改进版的 Transformer 模型,Tesla 对全车 8 个摄像头的画面进行坐标转换,并放置在同一个坐标系中(BEV 空间),这样就可以形成一个虚拟的向量空间。后续所有的分析和决策都在这个空间中进行,当所有的传感器都用同一种语言的时候,沟通就变得更方便了。由于坐标系相同,在这个空间中图像数据、毫米波雷达数据、激光雷达数据、高精地图数据都可以进行融合。

多摄像头融合输出 EID

BEV 大模型对车辆感知能力的提升使之成为兵家必争之地,理想汽车在 L7 的新品发布会上提到了智能驾驶方面的最新进展:全面切换到与清华大学联合开发的混合 BEV 框架,并实现了不同传感器类型的“可插拔”,使得一套算法同时兼容纯视觉感知和激光雷达增强感知;蔚来也在全新 NOP+ 开放测试时表示将在 2023 年上半年完成向 BEV 感知路线的切换,小鹏、毫末智行、百度Apollo 等厂商也先后分享了自家基于 BEV 的新一代感知架构的最新进展,目前,不管是理想 AD Max,蔚来 NOP+还是小鹏 NGP,感知能力和边界都较上一代产品有了大幅度提升,决策和规控也更加成熟,随着研发人员对人工智能模型和计算机视觉理解的进一步深入,等 BEV 算法正式推送到用户手中的时候,领航辅助驾驶产品才算到达历史上的“iPhone 节点”,完成了从能用到好用的跨越。

博威合金BOWAY

博威合金BOWAY 马扎克Mazak

马扎克Mazak 威尔泰克

威尔泰克 迈格泰克

迈格泰克 斯巴特

斯巴特 MAOSHENG贸盛

MAOSHENG贸盛 Miller米勒

Miller米勒 新世纪焊接

新世纪焊接 西安恒立

西安恒立 上海特焊

上海特焊 新天激光

新天激光 海目星激光

海目星激光 迅镭激光

迅镭激光 粤铭YUEMING

粤铭YUEMING 镭鸣Leiming

镭鸣Leiming 领创激光

领创激光 天琪激光

天琪激光 亚威Yawei

亚威Yawei 邦德激光bodor

邦德激光bodor 扬力YANGLI

扬力YANGLI 宏山激光

宏山激光 楚天激光

楚天激光 百超迪能NED

百超迪能NED 金运激光

金运激光 LVD

LVD Tanaka田中

Tanaka田中 BLM

BLM 易特流etal

易特流etal 百盛激光

百盛激光 Messer梅塞尔

Messer梅塞尔 PrimaPower普玛宝

PrimaPower普玛宝 Salvagnini萨瓦尼尼

Salvagnini萨瓦尼尼 奔腾激光PENTA LASER

奔腾激光PENTA LASER 华工HGTECH

华工HGTECH Bystronic百超激光

Bystronic百超激光 TRUMPF通快

TRUMPF通快 全自动焊接流水线

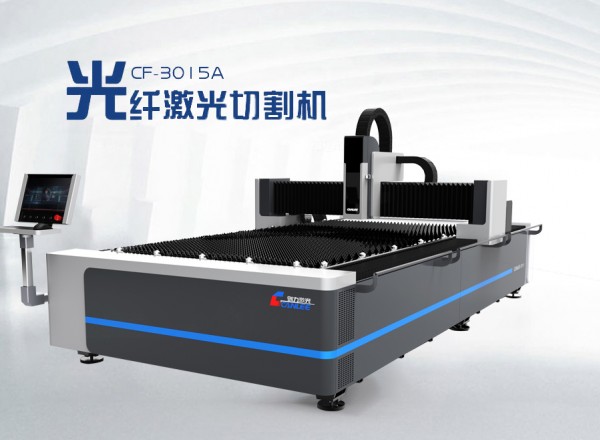

全自动焊接流水线 创力 CANLEE光纤激光切割机

创力 CANLEE光纤激光切割机 川崎工业焊接机器人 焊接管架

川崎工业焊接机器人 焊接管架 上海通用电气 全焊机系列展示

上海通用电气 全焊机系列展示 松下 旗下LAPRISS机器人激光焊接系统

松下 旗下LAPRISS机器人激光焊接系统 大焊 焊机匠心品质 精工之作 行家之选

大焊 焊机匠心品质 精工之作 行家之选 KUKA 库卡摩多机器人流水线作业

KUKA 库卡摩多机器人流水线作业 供应衬氟下展式放料阀厂家批发价格

供应衬氟下展式放料阀厂家批发价格 览众上升焊气保焊机

览众上升焊气保焊机 瑞凌东升MFR280高端数字脉冲气体保护焊机 气保焊机 二保焊机

瑞凌东升MFR280高端数字脉冲气体保护焊机 气保焊机 二保焊机 Welding Star 威施达500A 气保焊机送丝机

Welding Star 威施达500A 气保焊机送丝机 供应越达60T60T双立柱双回转变位机

供应越达60T60T双立柱双回转变位机 供应自调滚轮架、可调滚轮架、特殊滚轮架、行走滚轮架、机器人配套滚论架

供应自调滚轮架、可调滚轮架、特殊滚轮架、行走滚轮架、机器人配套滚论架 批发供应A302不锈钢焊条 E309-16焊条 白钢焊条

批发供应A302不锈钢焊条 E309-16焊条 白钢焊条 供应751645 420mAh 2C快充聚合物锂电池

供应751645 420mAh 2C快充聚合物锂电池