南加州大学的研究人员在Deepfake数据集和检测模型中存在偏见。一个普遍使用的数据集“绝大多数”是白人,尤其是白人女性。Deepfake检测器无法发现有色人种的欺诈性图像和视频。

行业中的许多人认为Deepfake算法的发展是如此迅速,以至于如此之快,以至于自动检测器将很快成为发现它们的唯一希望。

一个由研究员有三个为根据性别和种族中的误码率10.7%,差异知名deepfake探测器,发现尽可能多的尝试。

他们俩发现,尤其是流行的FaceForensics ++的平衡性很差。重要的是要注意对AI数据集中的偏见的关注是非常新的。随着改进,一段时间以来会出现更多的代表性不足的例子。

研究人员写道,在尝试发现假冒视频时,实现较低的假阳性率是一个“具有挑战性的问题”。

他们使用FaceForensics ++和Blended Image生物特征数据集,训练了MesoInception4,Xception和Face X射线模型,所有这些模型在视频检测中都“被证明是成功的”。这三个代表各种规模、架构和损失表述。

这三个检测器在男性和女性面部上的表现均相同,错误率的差异为0.1%至0.3%。用混合图像训练的检测器在显示较暗的非洲图像时效果最差,错误率相差3.5%至6.7%。

“混合图像”和“面部X射线”在处理白人男性面孔方面最为成功,所有白人面孔的错误率均为9.8%,白人男性的错误率为9.5%。

VentureBeat中的一篇文章对USC论文与去年科罗拉多大学博尔德分校,发表的另一篇论文进行了比较。根据该出版物,微软、Clarifai、亚马逊和其他公司编写的算法至少有95%的时间正确地识别了男性。

但是跨性别者中有38%的人将男性误认为女性。

一些研究人员正在研究面部生物特征活动性检测。一种努力认识到当血液在皮肤下以脉冲形式冲洗时,人的脸部会发生快速而细微的颜色变化。

Facebook仍因无法将危险的政治宣传与有关医疗保健的知情人士分开而烧伤,它在去年6月结束的Deepfake Detection Challenge中提供了100万美元的奖金。

博威合金BOWAY

博威合金BOWAY 马扎克Mazak

马扎克Mazak 威尔泰克

威尔泰克 迈格泰克

迈格泰克 斯巴特

斯巴特 MAOSHENG贸盛

MAOSHENG贸盛 Miller米勒

Miller米勒 新世纪焊接

新世纪焊接 西安恒立

西安恒立 上海特焊

上海特焊 新天激光

新天激光 海目星激光

海目星激光 迅镭激光

迅镭激光 粤铭YUEMING

粤铭YUEMING 镭鸣Leiming

镭鸣Leiming 领创激光

领创激光 天琪激光

天琪激光 亚威Yawei

亚威Yawei 邦德激光bodor

邦德激光bodor 扬力YANGLI

扬力YANGLI 宏山激光

宏山激光 楚天激光

楚天激光 百超迪能NED

百超迪能NED 金运激光

金运激光 LVD

LVD Tanaka田中

Tanaka田中 BLM

BLM 易特流etal

易特流etal 百盛激光

百盛激光 Messer梅塞尔

Messer梅塞尔 PrimaPower普玛宝

PrimaPower普玛宝 Salvagnini萨瓦尼尼

Salvagnini萨瓦尼尼 奔腾激光PENTA LASER

奔腾激光PENTA LASER 华工HGTECH

华工HGTECH Bystronic百超激光

Bystronic百超激光 TRUMPF通快

TRUMPF通快 上海通用电气 全焊机系列展示

上海通用电气 全焊机系列展示 KUKA 库卡摩多机器人流水线作业

KUKA 库卡摩多机器人流水线作业 川崎工业焊接机器人 焊接管架

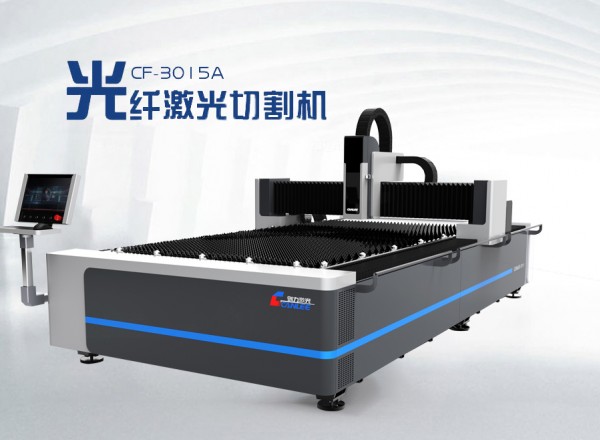

川崎工业焊接机器人 焊接管架 创力 CANLEE光纤激光切割机

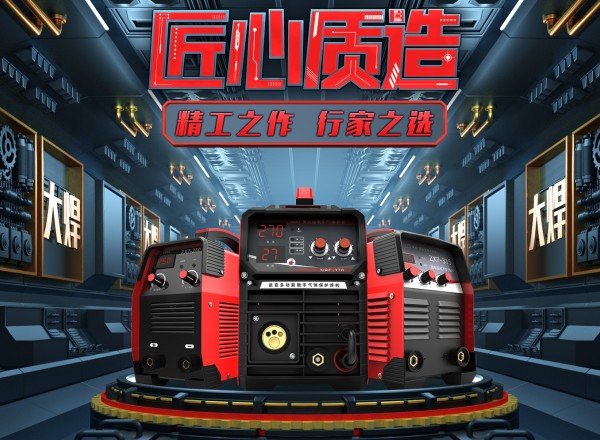

创力 CANLEE光纤激光切割机 大焊 焊机匠心品质 精工之作 行家之选

大焊 焊机匠心品质 精工之作 行家之选 松下 旗下LAPRISS机器人激光焊接系统

松下 旗下LAPRISS机器人激光焊接系统 全自动焊接流水线

全自动焊接流水线 厂家销售304材质圆孔板

厂家销售304材质圆孔板 供应博塔 自动焊 变位机

供应博塔 自动焊 变位机 江苏天岳010.20.2224 码垛机器人 焊接机器人 回转支承 现货供应

江苏天岳010.20.2224 码垛机器人 焊接机器人 回转支承 现货供应 成都华远焊机 交直流脉冲氩弧焊机 脉冲氩弧焊机 铝焊机

成都华远焊机 交直流脉冲氩弧焊机 脉冲氩弧焊机 铝焊机 气保焊机厂家 NB-500P成型好 . 免打磨焊机 二保焊机全国联保

气保焊机厂家 NB-500P成型好 . 免打磨焊机 二保焊机全国联保 瑞凌氩弧焊机WS-250S家用小型氩弧焊机保证 瑞凌

瑞凌氩弧焊机WS-250S家用小型氩弧焊机保证 瑞凌 聚英环保|干式喷漆墙 墙式漆雾净化装置 纸箱式漆雾墙

聚英环保|干式喷漆墙 墙式漆雾净化装置 纸箱式漆雾墙 览众电力建设自动氩弧焊机

览众电力建设自动氩弧焊机